Новое исследование, проведенное в Китае, предлагает улучшенный метод интерполяции разрыва между двумя видеокадрами с временной дистанцией –, что является одной из наиболее важных задач в нынешней гонке за реализм для генеративного видео искусственного интеллекта, а также для сжатия видеокодеков.

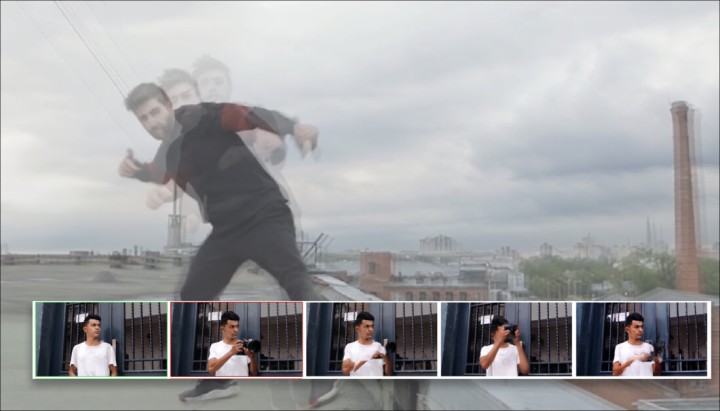

В приведенном ниже примере видео мы видим в крайнем левом столбце кадр ‘start’ (вверху слева) и ‘end’ (внизу слева). Задача, которую должны взять на себя конкурирующие системы, состоит в том, чтобы угадать, как субъект на двух изображениях перейдет от кадра A к кадру B. В анимации этот процесс называется подтягиваниеи возвращает нас к эпохе немого кино.

Нажмите, чтобы играть. В первом, крайнем левом столбце, мы видим предлагаемую начальную и конечную рамку. В среднем столбце и в верхней части третьего (самого правого) столбца мы видим три предыдущих подхода к решению этой задачи. В правом нижнем углу мы видим, что новый метод дает гораздо более убедительный результат в обеспечении интерстициальных рамок. Источник: https://fcvg-inbetween.github.io/

Новый метод, предложенный китайскими исследователями, называется Покадровая генерация видео на основе условий (FCVG), и его результаты можно увидеть в правом нижнем углу видео выше, обеспечивая плавный и логичный переход от одного неподвижного кадра к другому.

Напротив, мы видим, что одна из самых знаменитых платформ для видеоинтерполяции, проект Google Frame Interpolation for Large Motion (FILM), борется, поскольку многие подобные мероприятия борются с интерпретацией больших и смелых движений.

Два других конкурирующих фреймворка, визуализируемые в видео, Time Reversal Fusion (TRF) и Generative Inbetweening (GI), обеспечивают менее искаженную интерпретацию, но создали неистовые и даже комические танцевальные движения, ни одно из которых не уважает неявную логику двух поставляемых фреймов.

Нажмите, чтобы играть. Два несовершенных решения проблемы твининга. Слева FILM рассматривает эти два кадра как простые мишени морф. Да, TRF знает, что необходимо ввести какую-то форму танца, но предлагает неосуществимое решение, демонстрирующее анатомические аномалии.

Вверху слева мы можем более внимательно посмотреть, как FILM подходит к проблеме. Хотя FILM был разработан, чтобы иметь возможность обрабатывать большое движение, в отличие от предыдущих подходов, основанных на оптическом потоке, ему все еще не хватает семантического понимания того, что должно происходить между двумя предоставленными ключевыми кадрами, и он просто выполняет морф в стиле 1980/90-х годов. между кадрами. FILM не имеет семантической архитектуры, такой как модель скрытой диффузии, такая как стабильная диффузия, которая помогает создать соответствующий мост между кадрами.

Справа, в видео выше, мы видим усилия TRF, где стабильная диффузия видео (SVD) используется для более разумного ‘догадывания о том, как танцевальное движение, подходящее для двух кадров, предоставленных пользователем, может быть –, но оно сделало смелое и неправдоподобное приближение.

FCVG, как показано ниже, делает более надежную работу по угадыванию движения и содержания между двумя кадрами:

Нажмите, чтобы играть. FCVG совершенствует прежние подходы, но далек от совершенства.

Все еще существуют артефакты, такие как нежелательное морфирование рук и идентичность лица, но эта версия на первый взгляд является наиболее правдоподобной –, и любое улучшение современного уровня техники необходимо учитывать с учетом огромных трудностей, которые предлагает задача; и большое препятствие, которое эта проблема представляет для будущего видео, созданного с помощью искусственного интеллекта.

Почему Интерполяция имеет значение

Как мы уже отмечали ранее, возможность правдоподобно заполнять видеоконтент между двумя кадрами, предоставленными пользователем, является одним из лучших способов сохранить временную согласованность в генеративном видео, поскольку две реальные и последовательные фотографии одного и того же человека, естественно, будут содержать последовательные элементы. такие как одежда, волосы и окружающая среда.

Когда только а сингл используется стартовая рамка, окно ограниченного внимания генеративной системы, которая часто учитывает только близлежащие рамки, будет иметь тенденцию постепенно ‘эволюционировать грани предмета, пока (например) мужчина не станет другим мужчиной (или женщиной).) или оказывается, что у него ‘трансформирующаяся одежда – среди многих других отвлекающих факторов, которые обычно генерируются в системах T2V с открытым исходным кодом, и в большинстве платных решений, таких как Kling:

Нажмите, чтобы играть. Подача двух (настоящих) исходных рамок новой газеты в Клинг с подсказкой ‘»Человек, танцующий на крыше» не привела к идеальному решению. Хотя Kling 1.6 была доступна на момент создания, V1.5 является последней версией, поддерживающей стартовые и конечные кадры пользовательского ввода. Источник: https://klingai.com/

Проблема уже решена?

Напротив, некоторые коммерческие системы с закрытым исходным кодом и проприетарные системы, похоже, справляются с этой проблемой лучше –, особенно RunwayML, который смог создать очень правдоподобное промежуточное соединение двух исходных кадров:

Нажмите, чтобы играть. Интерполяция RunwayML на основе диффузии очень эффективна. Источник: https://app.runwayml.com/

Повторив упражнение, RunwayML дал второй, столь же достоверный результат:

Нажмите, чтобы играть. Второй запуск последовательности RunwayML.

Одна из проблем здесь заключается в том, что мы не можем ни узнать ничего о связанных с этим проблемах, ни улучшить современное состояние открытого исходного кода из собственной системы. Мы не можем знать, был ли этот превосходный рендеринг достигнут с помощью уникальных архитектурных подходов, данных (или методов курирования данных, таких как фильтрация и аннотация) или какой-либо комбинации этих и других возможных исследовательских инноваций.

Во-вторых, более мелкие компании, такие как компании, производящие визуальные эффекты, не могут в долгосрочной перспективе зависеть от услуг, основанных на B2B API, которые потенциально могут подорвать их логистическое планирование при единичном повышении цен –, особенно если одна услуга должна стать доминирующей на рынке и, следовательно, быть более склонной к повышению цен.

Когда права неправильные

Гораздо важнее то, что если хорошо работающая коммерческая модель будет обучена нелицензионным данным, как это, по-видимому, имеет место в случае с RunwayML, любая компания, использующая такие услуги, может рискнуть подвергнуться юридическому риску в дальнейшем.

Поскольку законы (и некоторые судебные иски) действуют дольше, чем президенты, и поскольку важнейший рынок США является одним из самых спорных в мире, нынешняя тенденция к усилению законодательного надзора за данными обучения ИИ, похоже, переживет ‘-легкий штрих Дональда Трампа. следующий президентский срок.

Поэтому сектору исследований компьютерного зрения придется на собственном горьком опыте решить эту проблему, чтобы любые новые решения могли сохраниться в долгосрочной перспективе.

ФКВГ

Новый метод Китая представлен в статье под названием Генеративное промежуточное соединение посредством генерации видео, управляемой условиями по кадрами принадлежит пяти исследователям из Харбинского технологического института и Тяньцзиньского университета.

FCVG решает проблему неоднозначности задачи интерполяции, используя рамочные условия, вместе с рамкой, которая очерчивает края в предоставленных пользователем начальных и конечных кадрах, что помогает процессу более последовательно отслеживать переходы между отдельными кадрами, а также общий эффект.

Кадровое обусловливание включает в себя разбиение создания промежуточных кадров на подзадачи вместо того, чтобы пытаться заполнить очень большой семантический вакуум между двумя кадрами (и чем длиннее запрошенный видеовыход, тем больше это семантическое расстояние).

На графике ниже, из статьи, авторы сравнивают вышеупомянутый метод реверса времени (TRF) со своим. TRF создает два пути генерации видео, используя предварительно обученную модель преобразования изображения в видео (SVD). Один из них представляет собой путь ‘вперед, обусловленный начальным кадром, а другой — путь ‘назад, обусловленный конечным кадром. Оба пути начинаются от одного и того же случайного шума. Это проиллюстрировано слева от изображения ниже:

Сравнение предыдущих подходов к FCVG. Источник: https://arxiv.org/pdf/2412.11755

Авторы утверждают, что FCVG является улучшением по сравнению с методами обращения во времени, поскольку он уменьшает двусмысленность в генерации видео, предоставляя каждому кадру свое собственное явное условие, что приводит к более стабильному и последовательному выводу.

Методы обращения времени, такие как TRF, утверждается в статье, могут привести к двусмысленности, поскольку пути прямой и обратной генерации могут расходиться, вызывая смещение или несоответствия. FCVG решает эту проблему, используя кадровые условия, полученные из согласованных линий между начальным и конечным кадрами (справа внизу на изображении выше), которые направляют процесс генерации.

Нажмите tо играй. Еще одно сравнение со страницы проекта FCVG.

Изменение времени позволяет использовать предварительно обученные модели генерации видео для промежуточного взаимодействия, но имеет некоторые недостатки. Движение, генерируемое моделями I2V, таково разнообразный а не стабильно. Хотя это полезно для задач «чистое изображение-видео» (I2V), оно создает двусмысленность и приводит к смещению или противоречивости видеопутей.

Изменение времени также требует трудоемкой настройки гиперпараметров, таких как частота кадров для каждого сгенерированного видео. Кроме того, некоторые методы, связанные с разворотом времени для уменьшения двусмысленности, значительно замедляют вывод, увеличивая время обработки.

Метод

Авторы отмечают, что если первая из этих проблем (разнообразие против стабильности) может быть решена, все остальные последующие проблемы, вероятно, решатся сами собой. Это было предпринято в предыдущих предложениях, таких как вышеупомянутый GI, а также ViBiDSampler.

В документе говорится

‘Тем не менее, [существует] все еще существует значительная стохастика между этими путями, тем самым ограничивая эффективность этих методов при работе со сценариями, включающими большие движения, такие как быстрые изменения человеческих поз. Неоднозначность в пути интерполяции в первую очередь возникает из-за недостаточных условий для промежуточных кадров, поскольку два входных изображения обеспечивают условия только для начального и конечного кадров.

‘Поэтому [мы] предлагаем предложить явное условие для каждого кадра, которое значительно облегчает неоднозначность пути интерполяции’

Мы можем увидеть основные концепции FCVG в работе на схеме ниже. FCVG генерирует последовательность видеокадров, которые начинаются и заканчиваются последовательно двумя входными кадрами. Это обеспечивает временную стабильность кадров за счет обеспечения условий, специфичных для конкретного кадра, для процесса генерации видео.

Схема вывода FCVG.

При таком переосмыслении подхода к изменению времени метод объединяет информацию как из прямого, так и из обратного направления, смешивая их для создания плавных переходов. Посредством итеративного процесса модель постепенно уточняет шумные входные данные до тех пор, пока не будет создан окончательный набор промежуточных кадров.

Следующий этап включает в себя использование предварительно обученной модели сопоставления линий GlueStick, которая создает соответствия между двумя рассчитанными начальным и конечным кадрами, с дополнительным использованием скелетных поз для управления моделью с помощью модели стабильной диффузии видео.

GlueStick черпает линии из интерпретируемых форм. Эти линии обеспечивают соответствующие якоря между стартовым и конечным кадрами в FCVG*.

Авторы отмечают

‘Мы эмпирически обнаружили, что линейная интерполяция достаточна для большинства случаев, чтобы гарантировать временную стабильность промежуточных видео, и наш метод позволяет пользователям указывать нелинейные пути интерполяции для генерации желаемых [видео]’

Рабочий процесс для установления прямых и обратных рамочных условий. Мы можем видеть совпадающие цвета, которые поддерживают согласованность контента по мере развития анимации.

Для внедрения полученных рамочных условий в SVD FCVG использует метод, разработанный для инициативы ControlNeXt 2024 года. В этом процессе условия управления первоначально кодируются несколькими блоками ResNet перед перекрестной нормализацией между ветвями условия и SVD рабочего процесса.

Для точной настройки модели SVD используется небольшой набор видеороликов, большинство параметров модели заморожены.

‘[вышеупомянутые ограничения] были в значительной степени решены в FCVG: (i) При явном указании условия для каждого кадра неоднозначность между прямым и обратным путями значительно облегчается; (ii) Вводится только один настраиваемый [параметр], при сохранении гиперпараметров в SVD по умолчанию, дает благоприятные результаты в большинстве сценариев; (iii) Простое среднее слияние, без повторного введения шума, является адекватным в FCVG, и этапы вывода можно существенно уменьшить на 50% по сравнению с [GI].’

Широкая схема внедрения кадровых условий в стабильную диффузию видео для FCVG.

Данные и тесты

Чтобы протестировать систему, исследователи создали набор данных, включающий различные сцены, включая внешнюю среду, человеческие позы и внутренние локации, включая такие движения, как движения камеры, танцевальные действия и выражения лица, среди прочего. 524 выбранных клипа были взяты из наборов данных DAVIS и RealEstate10k. Эта коллекция была дополнена видеороликами с высокой частотой кадров, полученными от Pexels. Кураторский набор был разделен на 4:1 между точной настройкой и тестированием.

Использованными метриками были Learned Perceptual Similarity Metrics (LPIPS); Fréchet Inception Distance (FID); Fréchet Video Distance (FVD); VBench; и Fréchet Video Motion Distance.

Авторы отмечают, что ни один из этих показателей не адаптирован для оценки временной стабильности, и отсылают нас к видеороликам на странице проекта FCVG.

Помимо использования GlueStick для сопоставления линий, DWPose использовалась для оценки поз человека.

Место инструмента точной настройки для 70 000 итераций под оптимизатором AdamW на графическом процессоре NVIDIA A800 со скоростью обучения 1×10-6, с рамками, обрезанными до 512×320 патчей.

Конкурирующими предыдущими протестированными платформами были FILM, GI, TRF и DynamiCrafter.

Для количественной оценки устраненные пробелы в кадрах варьировались от 12 до 23.

Количественные результаты по сравнению с предыдущими рамками.

Что касается этих результатов, в статье отмечается

‘[Наш] метод обеспечивает наилучшую производительность среди четырех генеративных подходов по всем показателям. Что касается сравнения LPIPS с FILM, наш FCVG незначительно уступает, демонстрируя при этом превосходную производительность по другим показателям. Учитывая отсутствие временной информации в LPIPS, возможно, было бы более целесообразным расставить приоритеты в других показателях и визуальном наблюдении.

‘Более того, сравнивая результаты при различных зазорах кадров, FILM может хорошо работать, когда зазор мал, в то время как генеративные методы больше подходят для большого зазора. Среди этих генеративных методов наш FCVG демонстрирует значительное превосходство благодаря явным рамочным условиям

Для качественного тестирования авторы создали видео, которые можно увидеть на странице проекта (некоторые из них встроены в эту статью), а также статические и анимированные результаты в PDF-документе

Образец статических результатов из статьи. Пожалуйста, обратитесь к исходному PDF-файлу для лучшего разрешения и имейте в виду, что PDF-файл содержит анимацию, которую можно воспроизводить в приложениях, поддерживающих эту функцию.

Авторы комментируют:

‘Хотя FILM дает плавные результаты интерполяции для сценариев малого движения, он борется с крупномасштабным движением из-за присущих оптическому потоку ограничений, что приводит к заметным артефактам, таким как фон и движение рук (в первом случае).

‘Генеративные модели, такие как TRF и GI, страдают от двусмысленностей в путях слияния, приводящих к нестабильному промежуточному движению, что особенно очевидно в сложных сценах, включающих движение человека и объекта.

‘Напротив, наш метод неизменно дает удовлетворительные результаты в различных сценарияхДаже при наличии значительной окклюзии (во втором и шестом случае) наш метод все равно может фиксировать разумное движение. Более того, наш подход демонстрирует устойчивость к сложным человеческим действиям (в последнем случае)

Авторы также обнаружили, что FCVG необычайно хорошо обобщает видео в стиле анимации:

Нажмите, чтобы играть. FCVG дает очень убедительные результаты для мультипликационной анимации.

Заключение

FCVG представляет собой, по крайней мере, постепенное улучшение современного состояния интерполяции кадров в непатентованном контексте. Авторы сделали код работы доступным на GitHub, хотя соответствующий набор данных на момент написания не был опубликован.

Если проприетарные коммерческие решения превосходят усилия по открытому исходному коду за счет использования нелицензированных данных с веб-скрэпом, будущее такого подхода, по-видимому, ограничено или отсутствует, по крайней мере, для коммерческого использования; риски просто слишком велики.

Таким образом, даже если сцена с открытым исходным кодом отстает от впечатляющей витрины нынешних лидеров рынка, возможно, именно черепаха может опередить зайца до финиша.

* Источник: https://openaccess.thecvf.com/content/ICCV2023/papers/Pautrat_GlueStick_Robust_Image_Matching_by_Sticking_Points_and_Lines_Together_ICCV_2023_paper.pdf

† Требуется Acrobat Reader, Okular или любой другой считыватель PDF-файлов, который может воспроизводить встроенную PDF-анимацию.

Впервые опубликовано в пятницу, 20 декабря 2024 г