В сообществе по синтезу ИИ в настоящее время происходит нечто примечательное, хотя его значимость может не сразу стать очевидной. Увлеченные люди обучают генеративные модели ИИ для видео, чтобы воспроизводить образы людей, используя основанные на видео LoRA на недавно выпущенной открытой платформе Hunyuan Video от Tencent.

Разнообразные результаты от настроек LoRA на основе Hunyuan, доступные бесплатно в сообществе Civit. Обучая модели низкоранговой адаптации (LoRAs), проблемы с временной стабильностью, которые два года беспокоили генерацию видео с помощью ИИ, значительно сокращаются. Источник: civit.ai

На видео, показанном выше, образы актрис Натали Портман, Кристины Хендрикс и Скарлетт Йоханссон, а также технологического лидера Илона Маска, были обучены в относительно небольшие дополнительные файлы для генеративной видео-системы Hunyuan, которые можно установить на компьютере пользователя без контент-фильтров (таких как фильтры NSFW).

Создатель LoRA Кристины Хендрикс, показанной выше, утверждает, что для разработки модели понадобилось всего 16 изображений из сериала Безумцы (что составляет всего 307 МБ для скачивания); множество постов из сообщества Stable Diffusion на Reddit и Discord подтверждают, что LoRAs такого рода не требуют больших объемов данных для обучения или длительного времени обучения в большинстве случаев.

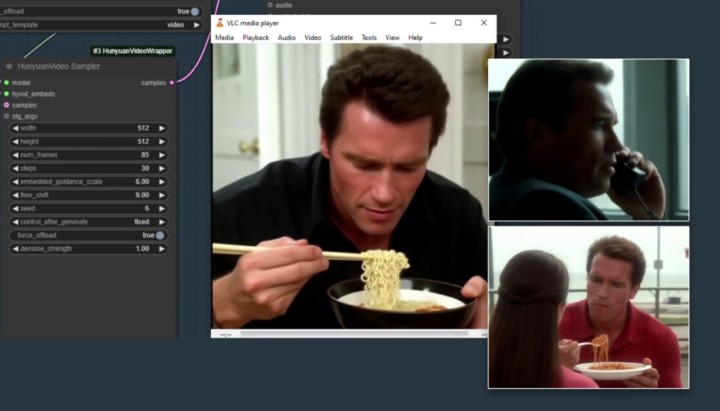

Арнольд Шварценеггер оживает в видео LoRA Hunyuan, которое можно скачать на Civit.

Смотрите видео для дополнительных примеров Арни от энтузиаста ИИ Боба Дойла.

LoRA Hunyuan может быть обучена как на статических изображениях, так и на видео, хотя обучение на видео требует больших аппаратных ресурсов и увеличенного времени обучения.

Модель Hunyuan Video содержит 13 миллиардов параметров, что превышает 12 миллиардов параметров Sora и значительно больше, чем менее мощная модель Hunyuan-DiT, выпущенная в открытый доступ летом 2024 года, которая имеет всего 1,5 миллиарда параметров.

Как и два с половиной года назад с Stable Diffusion и LoRA (смотрите примеры «нативных» знаменитостей Stable Diffusion 1.5 здесь), рассматриваемая базовая модель имеет значительно более ограниченное понимание личностей знаменитостей по сравнению с уровнем точности, который можно получить с помощью реализации LoRA с «инъекцией идентификации».

Фактически, индивидуализированная, ориентированная на личность LoRA получает «бесплатное преимущество» от значительных возможностей синтеза базовой модели Hunyuan, предлагая значительно более эффективный человеческий синтез, чем можно получить как с помощью глубинных подделок на автокодерах 2017 года, так и с помощью попыток добавить движение к статическим изображениям с помощью таких систем, как прославленный LivePortrait.

Все LoRA, изображенные здесь, можно бесплатно скачать из популярного сообщества Civit, в то время как более многочисленные старые индивидуальные «статические изображения» LoRA также могут потенциально создавать «начальные» изображения для процесса создания видео (то есть изображение в видео, ожидающий релиз для Hunyuan Video, хотя в данный момент возможны обходные пути).

Сверху представлены образцы ‘статического’ Flux LoRA

На момент написания статьи, сайт Civit предлагает 128 результатов поиска по запросу ‘Hunyuan’; почти все из них так или иначе являются NSFW моделями; 22 изображают знаменитостей; 18 предназначены для создания жесткой порнографии; и всего семь из них изображают мужчин, а не женщин.

Что нового?

Из-за развивающегося характера термина deepfake и ограниченного понимания общественностью (весьма серьезных) ограничений существующих на данный момент AI-рамок для синтеза видео с участием людей, значимость Hunyuan LoRA не так проста для понимания для человека, случайно следящего за сценой генеративного ИИ. Давайте рассмотрим некоторые ключевые различия между Hunyuan LoRA и предыдущими подходами к генерации видео на основе идентичности.

1: Неограниченная локальная установка

Самый важный аспект видео Hunyuan заключается в том, что его можно скачать локально, и что он предоставляет весьма мощную и нескользящую систему генерации видео ИИ в руки обычного пользователя, а также сообщества VFX (в той мере, в какой лицензии могут это позволять в разных регионах).

Последний раз нечто подобное произошло с выпуском модели Stable Diffusion от Stability.ai в летнем сезоне 2022 года. В то время DALL-E2 от OpenAI захватил общественное воображение, хотя DALLE-2 был платной службой с заметными ограничениями (которые со временем увеличивались).

Когда Stable Diffusion стал доступен, а Low-Rank Adaptation затем позволил генерировать изображения идентичности любого человека (знаменитости или нет), огромный интерес разработчиков и потребителей способствовал тому, чтобы Stable Diffusion затмил популярность DALLE-2; несмотря на то, что последний был более способной системой ‘из коробки’, его цензурные процедуры многими пользователями воспринимались как обременительные, а настройка была невозможна.

Возможно, аналогичная ситуация сейчас наблюдается между Sora и Hunyuan – или, точнее, между Sora-уровне проприетарными генеративными видео-системами и их открытыми аналогами, среди которых Hunyuan является первым – но, вероятно, не последним (здесь стоит отметить, что Flux в конечном итоге достигнет значительных успехов на фоне Stable Diffusion).

Пользователи, которые хотят создать выходные данные Hunyuan LoRA, но у которых нет достаточно мощного оборудования, могут, как и прежде, перенаправить GPU-часть обучения на онлайн-сервисы вычислений, такие как RunPod. Это не то же самое, что создание видео ИИ на платформах, таких как Kaiber или Kling, поскольку здесь нет семантической или основанной на изображениях фильтрации (цензуры), связанной с арендой онлайн GPU для поддержки локального рабочего процесса.

2: Нет необходимости в ‘хост’ видео и высоких усилиях

Когда deepfake ворвались в мир в конце 2017 года, анонимно опубликованный код развился в основные форки DeepFaceLab и FaceSwap (а также систему глубокой подмены лиц DeepFaceLive в реальном времени).

Этот метод требовал кропотливого подбора тысяч изображений лиц для каждой идентичности, которую нужно было заменить; чем меньше усилий было приложено на этом этапе, тем менее эффективной становилась модель. Кроме того, время обучения варьировалось от 2 до 14 дней в зависимости от доступного оборудования, что стрессовало даже мощные системы в долгосрочной перспективе.

Когда модель наконец была готова, она могла накладывать лица на существующее видео и, как правило, требовалась ‘целевая’ (т.е. реальная) идентичность, которая была близка по внешнему виду к накладываемой идентичности.

Недавно ROOP, LivePortrait и множественные аналогичные конструкции предоставили схожую функциональность с гораздо меньшими усилиями и часто с лучшими результатами – но без возможности генерировать точные полност тела deepfake – или любой элемент, кроме лиц.

В отличие от этого, Hunyuan LoRA (и подобные системы, которые неизбежно возникнут) позволяют без ограничений создавать целые миры, включая полное моделирование идентичности, обученной пользователем LoRA.

3: Значительное улучшение временной согласованности

Временная согласованность остаётся Святой Грааль видео диффузии уже несколько лет. Использование LoRA вместе с соответствующими подсказками дает генерации видео Hunyuan постоянную ссылку на идентичность, к которой можно обращаться. В теории (это ранние дни), можно было бы обучить несколько LoRA одной и той же идентичности, каждая из которых носит определенную одежду.

При этих условиях вероятность ‘мутации’ одежды в процессе генерации видео также становится меньше (поскольку генеративная система основывает следующий кадр на очень ограниченном окне предыдущих кадров).

(В качестве альтернативы, как и в системах LoRA на основе изображений, можно просто применить несколько LoRA, такие как идентичность + костюм LoRA, к одной генерации видео)

4: Доступ к ‘Человеческому эксперименту’

Как я уже упоминал, сектор проприетарного и FAANG-уровня генеративного ИИ сейчас кажется таким настороженным в отношении потенциальной критики касательно способностей синтеза людей своих проектов, что реальные люди редко появляются на страницах проектов для крупных анонсов и выпусков. Вместо этого сопутствующая рекламная литература все чаще показывает ‘милых’ и иначе ‘нетревожащих’ субъектов в сгенерированных результатах.

С появлением Hunyuan LoRA, впервые у сообщества есть возможность расширить границы синтеза видео человека на базе LDM в очень способной (а не маргинальной) системе и полностью исследовать тему, которая интересует большинство из нас – людей.

Последствия

Поскольку поиск ‘Hunyuan’ в сообществе Civit в основном показывает LoRA для знаменитостей и ‘жесткой’ LoRA, центральное последствие появление Hunyuan LoRA заключается в том, что они будут использоваться для создания AI-порнографических (или иначе клеветнических) видео реальных людей – как знаменитостей, так и незнакомцев.

В целях соблюдения правил хоббисты, создающие Hunyuan LoRA и экспериментирующие с ними на различных серверах Discord, осторожно запрещают публиковать примеры реальных людей. Тем не менее, реальность такова, что даже изображенческие deepfake теперь стали серьезным оружием; и перспектива добавления действительно реалистичных видео в смесь, возможно, наконец оправдает усиливающиеся страхи, которые уже семь лет регулярно появляются в СМИ и стали поводом для новых регуляций.

Движущая сила

Как и прежде, порно является движущей силой технологий. Как бы мы ни относились к такому использованию, этот неумолимый источник импульса ведет к достижениям в современном искусстве, которые в конечном итоге могут способствовать более широкому принятию.

В данном случае возможно, что цена будет выше, чем обычно, поскольку открытие гиперреалистичного создания видео имеет очевидные последствия для криминального, политического и этического злоупотребления.

Одна группа Reddit (название которой я здесь не назову) посвящена генерации контента видео NSFW на основе ИИ и имеет связанный открытый сервер Discord, где пользователи улучшают рабочие процессы ComfyUI для генерации порно-видео на основе Hunyuan. Каждый день пользователи публикуют примеры NSFW клипов – многие из которых можно разумно отнести к ‘экстремальным’ или, по крайней мере, нарушающим ограничения, указанные в правилах форума.

Это сообщество также поддерживает значительный и хорошо разработанный репозиторий GitHub, содержащий инструменты, которые могут загружать и обрабатывать порнографические видео, чтобы предоставить обучающие данные для новых моделей.

Поскольку наиболее популярный тренер LoRA, Kohya-ss, теперь поддерживает обучение Hunyuan LoRA, барьеры для входа в необозначенное обучение генерации видео ежедневно снижаются, наряду с требованиями к оборудованию для обучения и генерации видео Hunyuan.

Ключевым аспектом подготовленных учебных схем для порно-ориентированного ИИ (в отличие от моделей, основанных на идентичности, таких как знаменитости) является то, что стандартная базовая модель, такая как Hunyuan, не специально обучена на выходных данных NSFW и, следовательно, может либо плохо справляться с задачей генерации NSFW-контента, либо не сможет разграничивать изученные концепции и ассоциации в убедительной или убедительной манере.

Развивая настроенные модели NSFW и LoRA, будет все более возможно проецировать обученные идентичности в специализированную область видео ‘порно’; в конце концов, это всего лишь видео-версия того, что уже произошло с неподвижными изображениями за последние два с половиной года.

VFX

Огромное увеличение временной согласованности, которое предлагает Hunyuan Video LoRA, очевидно, является благом для индустрии визуальных эффектов ИИ, сильно полагающейся на адаптацию программного обеспечения с открытым исходным кодом.

Хотя подход Hunyuan Video LoRA генерирует весь кадр и окружение, компании VFX, вероятнее всего, уже начали экспериментировать с разделением временно- согласованных человеческих лиц, которые можно получить этим методом, чтобы наложить или интегрировать лица в реальные исходные кадры.

Как и хоббийное сообщество, компании VFX должны ждать функциональности 이미지-видео и видео-видео Hunyuan, которая потенциально является самым полезным мостом между контентом ‘deepfake’ на основе идентичности, управляемым LoRA; или же импровизировать и использовать интервал для исследования потенциальных возможностей фреймворка и адаптаций, а также возможных проприетарных внутренних модификаций Hunyuan Video.

Несмотря на то, что условия лицензии Hunyuan Video технически допускают изображение реальных личностей, если получено разрешение, они запрещают его использование в ЕС, Великобритании и Южной Корее. По принципу ‘остается в Вегасе’, это не обязательно означает, что Hunyuan Video не будет использоваться в этих регионах; однако перспектива внешних аудитов данных, чтобы контролировать растущие регуляции вокруг генеративного ИИ, может сделать такое незаконное использование рискованным.

Одна другая потенциально неясная область условий лицензии гласит:

‘Если на дату выпуска версии Tencent Hunyuan количество активных пользователей всех продуктов или услуг, доступных Лицензиату, превышает 100 миллионов активных пользователей в текущем календарном месяце, вы должны запросить лицензию у Tencent, которую Tencent может предоставить вам по своему усмотрению, и вы не уполномочены осуществлять любые из прав в рамках данного Соглашения, если или до тех пор, пока Tencent не предоставит вам такие права явно.

Этот пункт явно нацелен на множество компаний, которые, вероятнее всего, ‘будут посредниками’ Hunyuan Video для относительно технически неграмотного круга пользователей и которые будут обязаны включить Tencent в дело при превышении определенного потолка пользователей.

Неясно, охватывает ли широкая формулировка также косвенное использование (т.е. через предоставление Hunyuan-совместимого визуального эффекта в популярных фильмах и ТВ) и требует уточнения.

Заключение

Поскольку deepfake видео существует уже давно, было бы легко недооценить значимость Hunyuan Video LoRA как подхода к синтезу идентичности и deepfaking; и предположить, что разработки, которые в настоящее время проявляются в сообществе Civit и связанных Discord и сабреддитах, представляют собой лишь незначительное продвижение к действительно контролируемому синтезу видео человека.

Скорее всего, текущие усилия представляют собой лишь фракцию потенциала Hunyuan Video по созданию полностью убедительных full-body и full-environment deepfakes; как только компонент image-to-video будет представлен (согласно слухам он должен появиться в этом месяце), более гранулярный уровень генеративной мощности станет доступен как для хоббистов, так и для профессионалов.

Когда Stability.ai выпустила Stable Diffusion в 2022 году, многие наблюдатели не могли понять, почему компания просто так отдает то, что тогда было столь ценным и мощным генеративным инструментом. С Hunyuan Video мотивация прибыли встроена непосредственно в лицензию – хотя, возможно, будет трудно для Tencent определить, когда компания запускает схему распределения прибыли.

В любом случае, результат таков же, как и в 2022 году: вокруг релиза сразу же и с высокой страстью сформировались сообщества разработчиков. Некоторые из направлений, которые эти усилия могут принять в ближайшие 12 месяцев, вероятно, приведут к новым заголовкам.